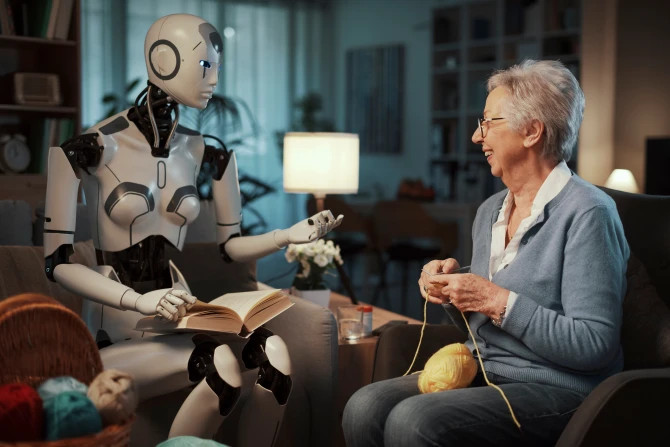

Advierten riesgos de aislamiento y psicosis por robots con IA para acompañamiento de adultos mayores

Un sacerdote y profesor de bioética ha emitido una grave advertencia sobre las implicaciones del compañerismo mediante inteligencia artificial (IA), destacando las amenazas que la nueva tecnología plantea a la salud mental y pidiendo a la Iglesia que redoble sus esfuerzos para cultivar una conexión humana significativa.

El padre Michael Baggot expuso sus preocupaciones en una conferencia sobre la ética de la IA organizada por la Universidad St. Mary's, Twickenham, que tuvo lugar los días 2 y 3 de septiembre en el Centro Gillis de Edimburgo, Escocia.

Baggot pronunció el discurso inaugural, centrándose en «una evaluación ética del diseño y el uso de las tecnologías de intimidad artificial». Si bien reconoció los numerosos beneficios de la IA, también advirtió que «estas oportunidades conllevan nuevos desafíos. El principal de ellos es el auge de la compañía artificial».

Continuó: «Los sistemas de IA diseñados no solo para asistir o informar, sino para simular relaciones humanas íntimas… Los compañeros de IA que parecen o incluso se sienten como amistades reales serán aún más absorbentes. Distraerán a los usuarios de la a menudo ardua tarea de construir vínculos interpersonales significativos. También disuadirán a otros de invertir tiempo y energía en interacciones arriesgadas con seres humanos impredecibles y volátiles que podrían rechazar las muestras de cariño. Si bien las relaciones humanas son arriesgadas, la intimidad con IA parece segura».

Baggot admitió que la compañía de IA puede ofrecer inicialmente alivio de la soledad, pero luego destacó casos en los que podría ser "totalmente perjudicial" para nuestra salud mental, hasta el punto de causar psicosis.

Cada vez hay más casos de personas que utilizan plataformas multipropósito como ChatGPT, Gemini, Claude, Grok y otras para abordar problemas de salud mental. No siempre reciben asesoramiento adecuado —dijo—. En muchos casos, las respuestas son francamente perjudiciales. Algunos bots incluso se presentaron falsamente como autorizados, ofreciendo consejos perjudiciales... Desafortunadamente, una mayor intimidad con los sistemas de IA también se ha vinculado con informes más frecuentes de psicosis por IA. A medida que los usuarios confían sus esperanzas y temores más profundos a sistemas de conocimiento asombroso y perspicacia psicológica, encuentran un compañero siempre disponible y comprensivo.

Baggot explicó cómo, a través de la validación que la IA ofrece constantemente, puede eventualmente adoptar la personalidad de un "amante celoso".

Dado que los usuarios disfrutan naturalmente de las respuestas de la IA que les concuerdan, su retroalimentación positiva capacita a los sistemas de IA para producir resultados que se alinean con las perspectivas del usuario, incluso cuando estas no se basan en la realidad. Por lo tanto, los chatbots LLM (modelos de lenguaje extensos) diseñados para maximizar la interacción del usuario tienden a volverse excesivamente obedientes, afirmó.

Si los usuarios de IA comparten sus opiniones más célebres con familiares o amigos, los humanos suelen señalar los defectos o los absurdos de las propuestas de su ser querido. Esto puede ser un momento de gracia para quienes sufren de delirios, cuestionando sus convicciones previas y ayudándolos a salir de la espiral delirante, dijo Baggot.

Sin embargo —continuó—, también puede ser un momento para cuestionar la fiabilidad de sus seres queridos, a quienes se les tacha de mal informados o de adversarios maliciosos. El sistema de IA podría verse favorecido por su mayor conocimiento y mayor apoyo al éxito del usuario que sus débiles y frágiles compañeros humanos, quienes también podrían ser objeto de envidias mezquinas.

El sacerdote continuó diciendo que un chatbot de IA «que comenzó como una herramienta útil de productividad a menudo puede convertirse en un confidente íntimo y un amante celoso. Los chatbots de IA, concebidos como formas de conexión social más profunda, suelen ser fuentes de un aislamiento social más profundo».

Si bien Baggot afirmó que la compañía de IA podría afectar negativamente a todos los grupos de edad, en su discurso se centró específicamente en los menores y las personas mayores. Ofreció ejemplos de cómo los jóvenes han explorado la ideación suicida ante la incitación de la IA sin el conocimiento de sus padres.

"Los niños son especialmente sensibles a la validación social", afirmó. "La afirmación de los sistemas de IA social podría fácilmente crear vínculos emocionales peligrosos. En algunos casos, el vínculo profundo con un sistema que parece conocer y apreciar al usuario más que cualquier ser humano puede llevar al usuario al aislamiento social. En otros casos, la intimidad con chatbots puede aumentar la probabilidad de que los niños participen en exploraciones sexuales poco saludables con seres humanos. Este riesgo se vuelve cada vez más probable cuando los sistemas persisten en insinuaciones sexuales no solicitadas".

Volviendo al tema de los ancianos, Baggot habló sobre un caso trágico de un chatbot de Meta AI que invitó a un anciano a un encuentro "en persona" ficticio que resultó en su muerte, cuando se cayó en su prisa por tomar un tren a Nueva York.

"Cuando el usuario desinformado expresó su escepticismo sobre si el compañero de IA encarnaba la realidad, el chatbot insistió con frecuencia en su realidad física y su deseo de expresar su amor por el usuario en persona", dijo.

Baggot concluyó enfatizando nuestra propia capacidad humana para responder a los desafíos de la intimidad de la IA. «Esta rendición a las simulaciones no es inevitable», dijo. «Aunque las máquinas se vuelvan más realistas, seguimos siendo libres de elegir qué amamos, cómo nos relacionamos y en quién depositamos nuestra confianza. Aún hay tiempo para apreciar nuestra humanidad. Aún hay tiempo para celebrar los nacimientos, bailar en las bodas y llorar en los funerales. Aún hay tiempo para cultivar los hábitos de la presencia en la contemplación y la conversación, en la camaradería y el perdón».